Quand l’IA échoue face au réel : ce que l’expérience du gratte-ciel et du trombone dit vraiment des limites des LLM

Une expérience simple, un constat brutal

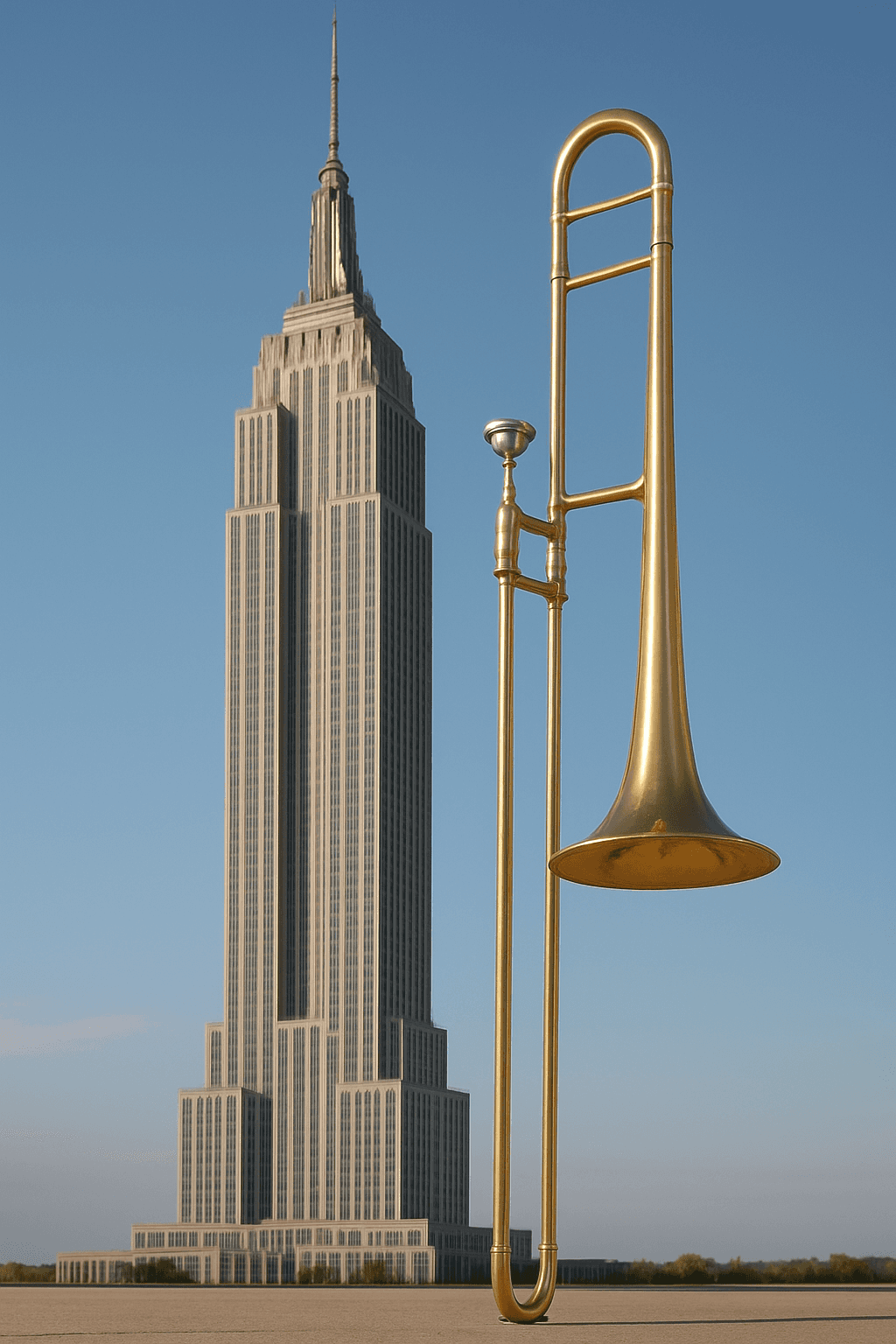

Je viens de lire un article qui illustre de manière parfaite ces situations ou l'IA nous rend chèvres. Prenez une IA générative et demandez-lui de représenter côte à côte un gratte-ciel et un trombone à coulisse pour comparer leurs tailles.

Le résultat frôle l’absurde : les deux objets apparaissent à peu près à la même échelle. Aucun enfant ne s’y tromperait, mais les IA les plus avancées s’y perdent.

Dans son article publié sur The Conversation, Frédéric Prost, maître de conférences à l’INSA Lyon, utilise cette expérience pour exposer une réalité dérangeante : malgré leur fluidité linguistique et leurs prouesses apparentes, les modèles actuels n’ont aucune représentation interne du monde physique.

Son analyse — Quand l’IA fait n’importe quoi, le cas du gratte-ciel et du trombone à coulisse — montre que les systèmes testés (ChatGPT, Gemini, Mistral) échouent tous de manière spectaculaire. Ce n’est pas un bug : c’est un symptôme structurel.

Pourquoi ces modèles échouent

Prost rappelle une chose essentielle :

les LLM ne raisonnent pas, ils prédisent.

Un LLM prédit le mot suivant.

Un modèle de diffusion apprend à reconstruire des images bruitées.

Aucun ne possède un mécanisme intégré de compréhension spatiale ou physique.

Les données d’entraînement expliquent beaucoup : les IA ont vu des gratte-ciel, elles ont vu des trombones, mais elles n’ont jamais appris ce que signifie les comparer visuellement.

C’est ce qui conduit aux incohérences majeures, comme l’exemple devenu célèbre de l’année 1776 :

Gemini calcule correctement qu’elle est bissextile… puis conclut malgré tout que les États-Unis ont été fondés « lors d’une année normale ».

La logique est absente : seule la continuité statistique guide la réponse.

Le regard de Yann LeCun : une critique plus profonde

Les observations de Prost rejoignent point par point les critiques de Yann LeCun, ex chief scientist IA chez Meta et l’un des principaux architectes du deep learning moderne.

Pour lui, les LLM actuels sont voués à l’obsolescence : leur structure même les empêche d’appréhender les phénomènes continus ou dynamiques du monde réel.

L’analogie des étudiants

LeCun résume souvent la situation ainsi :

les LLM sont comme des étudiants qui apprennent par mémorisation brute. Ils excellent aux tests tant qu’ils ressemblent à ceux qu’ils ont déjà vus. Dès que l’on s’éloigne du périmètre appris, tout s’effondre.

C’est exactement ce que montre l’expérience de Prost.

Les quatre manques fondamentaux

Selon LeCun, les LLM n’ont :

ni représentation du monde physique,

ni mémoire persistante,

ni capacité de raisonnement,

ni capacité de planification.

Ce ne sont pas des limitations accidentelles :

ce sont les murs porteurs de leur architecture.

LeCun le formule de manière provocatrice mais juste :

« Un chat comprend mieux le monde que n’importe quel LLM. »

Un décalage immense avec l’apprentissage humain

Malgré des volumes d’entraînement équivalents à 170 000 ans de lecture, les LLM échouent sur des tâches que les nourrissons maîtrisent intuitivement.

Ils n’ont pas de permanence des objets, pas de sens des interactions physiques, pas de notion d’impossible.

L’alternative : les modèles du monde prédictifs

Face à ce blocage structurel, LeCun défend une approche nouvelle : les architectures JEPA (Joint Embedding Predictive Architecture).

Contrairement aux LLM, JEPA ne prédit pas des pixels ni des mots : il prédit des représentations abstraites, un peu comme le fait le cerveau.

L’idée est simple :

nous n’imaginons pas les futurs possibles comme une séquence d’images parfaites, mais comme des interactions d’objets.

Meta a déjà publié :

I-JEPA pour les images,

V-JEPA pour les vidéos.

Ces modèles réagissent immédiatement lorsqu’une scène viole les lois de la physique, preuve qu’ils apprennent autre chose qu’un simple motif statistique.

LeCun pense que si cette trajectoire continue, elle pourrait supplanter l’approche LLM d’ici trois à cinq ans.

Une adoption massive… et une incertitude croissante

L’article de Prost intervient dans un contexte paradoxal.

ChatGPT n’a que trois ans, mais il compte déjà des centaines de millions d’utilisateurs hebdomadaires.

Pourtant, la technologie reste mal comprise : on la surestime et on la sous-estime à la fois.

Les IA produisent aujourd’hui autant de contenu que les humains.

Elles sont déjà intégrées dans l’éducation, le travail, la création.

Et pourtant, leur “intelligence” reste essentiellement linguistique et statistique.

L’écart entre la perception publique et la réalité technique n’a jamais été aussi grand.

Liens de l'article de Frédéric Post